Intelligenza Artificiale e Natural Language Processing: come migliorano la gestione di documenti e processi

AI is the new black. Si parla molto di Natural Language Processing, ma come si applica al mondo della gestione di documenti, processi e informazioni? Come stiamo integrando queste tecnologie nelle nostre soluzioni?

Vi raccontiamo il lavoro del nostro Team R&D su questo tema affascinante e innovativo.

Cosa sono l’AI generativa e i Large Language Model

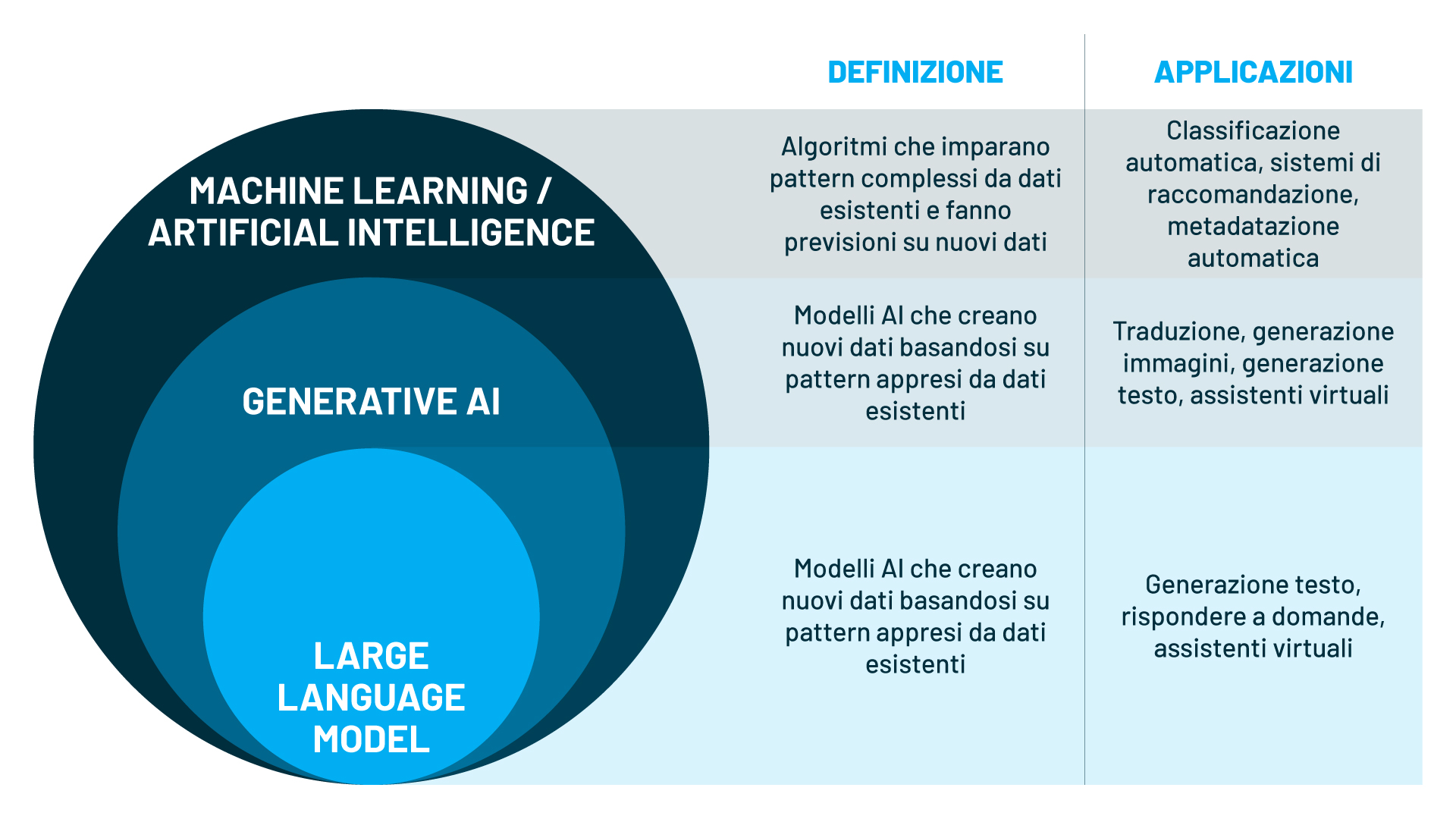

Nel campo della tecnologia, si sente sempre di più parlare di termini come AI, Machine Learning (ML), AI generativa e Large Language Model (LLM). Ma cosa significano esattamente questi termini e come si collegano tra loro?

L’AI consiste nello sviluppo di sistemi capaci di svolgere attività che normalmente richiedono capacità cognitive, come ragionare, capire e risolvere problemi, avvalendosi di vari metodi e tecniche, tra cui il Machine Learning.

Il Machine Learning è una branca dell’AI che si focalizza sull’apprendimento automatico. Gli algoritmi di ML sono in grado di riconoscere e apprendere pattern complessi da dati di addestramento e utilizzarli per fare previsioni su nuovi dati. Ad esempio, può essere usato per classificare automaticamente i documenti in base al loro contenuto.

L’AI generativa è un sottoinsieme dell’AI che usa algoritmi di Machine Learning per generare nuovi dati sfruttando i pattern appresi dai dati di addestramento. Pertanto, può essere usata per creare contenuti di vario tipo, come traduzioni, testi, immagini o altre forme di contenuto.

I Large Language Model sono modelli di AI generativa che operano nell’ambito dell’elaborazione del Natural Language Processing. I Large Language Model sono in grado di comprendere e generare testi coerenti e creativi utilizzando conoscenze apprese da grandi quantità di dati testuali. Ad esempio, può essere usato per scrivere un articolo, una recensione o rispondere a delle domande.

Esaminiamoli più nel dettaglio.

Large Language Model: i giganti del linguaggio naturale

I Large Language Model (LLM) si contraddistinguono per le loro notevoli dimensioni: contengono miliardi di parametri e si allenano su tantissimi dati che provengono da diversi tipi di testi (come testi letterali, articoli, chat online) per imparare una grande varietà di argomenti e stili di scrittura.

Grazie a queste caratteristiche, i LLM possono capire e produrre linguaggio naturale, seguire un filo logico e rispondere a delle istruzioni precise, come scrivere in un certo modo o usare certe parole.

I LLM sono la base di molte applicazioni avanzate. Tra queste, ci sono ChatGPT e Bard, che usano dei LLM appositi per parlare con gli utenti in modo conversazionale.

Le sfide dei Large Language Model: come gestire le informazioni generate

I LLM sono dei modelli molto potenti, ma hanno anche dei problemi che dobbiamo considerare.

Innanzitutto, possono manifestare ciò che viene comunemente chiamato allucinazioni. In altre parole, potrebbero generare informazioni inesatte o addirittura false. Questo fenomeno deriva dal fatto che i LLM generano testo basandosi su statistiche apprese dai dati di addestramento, il che talvolta può portarli a inventare o fraintendere le informazioni. Inoltre, non dicono da dove prendono le informazioni che scrivono e questo rende difficile verificare se le informazioni sono corrette o meno.

Infine, va tenuto presente che i LLM si basano esclusivamente sui dati di addestramento da cui hanno imparato, il che significa che le informazioni da loro generate si limitano a quanto hanno incontrato nei testi utilizzati per il loro apprendimento e non includono conoscenze esterne, come informazioni riservate di un’azienda o aggiornamenti in tempo reale.

Retrieval-Augmented Generation: un approccio innovativo per la generazione di testi

La Retrieval-Augmented Generation (RAG) è una soluzione che sfrutta al meglio le capacità dei LLM e allo stesso tempo supera i loro limiti.

La RAG è un approccio che combina l’intelligenza dei LLM con la capacità di reperire informazioni da fonti esterne affidabili, come ad esempio il sistema documentale di un’azienda. In questo modo, si ottiene una generazione di testi più precisa e verificabile.

Come funziona la RAG? Il processo è il seguente:

- Quando le persone pongono una domanda, il sistema usa un motore di ricerca per trovare documenti e informazioni pertinenti che rispondono alla domanda.

- Queste informazioni vengono poi inserite nel contesto che viene fornito al LLM, in modo che quest’ultimo possa usarle per generare una risposta chiara e concisa.

- La risposta generata dal LLM viene poi restituita alle persone, insieme alle fonti delle informazioni usate.

Il vantaggio principale della RAG è che le risposte generate sono più accurate e credibili, in quanto si basano su fonti esterne consultabili. Questo è molto importante per garantire la qualità delle informazioni fornite agli individui.

Per trovare documenti affidabili da usare nella RAG, è necessario usare un metodo di ricerca efficace. Infatti, se non si trovano i documenti rilevanti per rispondere alla domanda della persona, il LLM non sarà in grado di rispondere in modo pertinente. In questo scenario, la ricerca semantica è la soluzione ideale in quanto si basa su un tipo di ricerca che va oltre le parole chiave e interpreta il significato dei testi e delle query effettuate, riuscendo a trovare documenti che parlano di argomenti simili, anche se usano termini diversi. Il vantaggio principale è che permette di reperire informazioni più rilevanti e coerenti con la domanda della persona, senza doversi preoccupare delle parole chiave esatte.

Ricerca generativa: un esempio di come la RAG migliora la ricerca di informazioni

Normalmente, quando usiamo un motore di ricerca, dobbiamo inserire delle parole chiave e poi esaminare una lista di risultati per trovare le informazioni che cerchiamo. Questo processo manuale talvolta può richiedere molto tempo.

Con la RAG, invece, possiamo usare un motore di ricerca generativo, che sfrutta i Language Model per creare le risposte. In questo modo, possiamo formulare la nostra domanda in modo naturale e ricevere una risposta sintetica e diretta, basata su informazioni provenienti da diverse fonti.

Questo rende la ricerca di informazioni molto più semplice e veloce. Non dobbiamo più perdere tempo a cercare tra i risultati di ricerca e leggere i documenti; invece, otteniamo una risposta chiara e completa in un solo passaggio.

Come stiamo integrando le nuove tecnologie nelle nostre soluzioni per la gestione di documenti e processi

Il nostro Team di R&D formato da specialisti in AI e Innovazione opera da diversi anni su queste tematiche e sulle possibili applicazioni in ambito documentale, per mantenere il nostro impegno nei confronti dell’innovazione continua e della fornitura di soluzioni all’avanguardia.

Il Team di R&D lavora in stretta collaborazione con il Team di Sviluppo, al fine di garantire un’integrazione armoniosa delle funzionalità intelligenti nelle soluzioni che offriamo. La sinergia tra questi due gruppi è cruciale per tradurre le idee innovative in applicazioni pratiche, contribuendo così a potenziare le nostre soluzioni e ad anticipare le esigenze del mercato.

Alcuni dei progetti su cui stiamo lavorando sono:

- Interfacce conversazionali e chatbot per interagire con i sistemi informativi e porre domande su documenti lunghi e complessi o su grandi basi documentali, ottenendo risposte chiare e precise. I chatbot sono utili per offrire un servizio più personalizzato, accessibile e intuitivo all’utente, per rispondere alle sue domande, per fornire assistenza e per guidare le scelte.

- Rilevamento automatico dei dati sensibili all’interno dei documenti per individuare e proteggere tutti i dati sensibili come nome, data di nascita, codice fiscale e altri dati in base a dei criteri prestabiliti. Questa attività è importante per garantire il rispetto del GDPR (General Data Protection Regulation), che regola il trattamento dei dati personali nell’Unione Europea.

- Ricerca assistita per aiutare le persone a trovare i documenti di interesse, suggerendo dei termini con cui completare le query, in base al contesto e al dominio dei documenti, in modo simile a quanto offre Google (“forse stavi cercando…”) quando si digita una query incompleta o errata. Questa tecnica permette di migliorare la precisione e la rilevanza dei risultati e di facilitare la scoperta dei documenti di interesse.

- Tagging e metadatazione automatica per completare in modo automatico i metadati dei documenti, ovvero le informazioni aggiuntive che descrivono il contenuto, la provenienza, la data, l’autore o l’autrice e altre caratteristiche. Questa attività si basa sull’analisi del contenuto dei documenti e assegna i metadati più appropriati in base a dei criteri predefiniti o appresi dai dati. Il tagging e la metadatazione automatica sono utili per semplificare e velocizzare il caricamento dei documenti, evitando di dover inserire manualmente i metadati, e per migliorare la gestione, l’organizzazione e la ricerca delle informazioni.

- Estrazione dati da documenti non strutturati per riconoscere e recuperare le informazioni rilevanti da documenti che non hanno una forma predefinita, come testi, immagini, in base all’analisi del loro contenuto. Diversamente dalla metadatazione automatica, questo tipo di estrazione dei dati non si basa su criteri specifici, ma cerca di intuire quali informazioni ha senso estrarre in base al contenuto e allo scopo del documento, utile per creare delle sintesi informative e per supportare le decisioni.

- Classificazione automatica dei documenti e delle email, senza alcun intervento manuale, per snellire il lavoro delle persone e recapitare più rapidamente le comunicazioni. Per realizzare questa attività, abbiamo integrato con successo AI Classifier all’interno del PEC Manager di Archiflow, la nostra Information Service Platform. In questo modo, in combinazione con un sistema di smistamento basato su regole, possiamo attivare dei meccanismi di inoltro automatico delle email all’incaricato in base alla classificazione del messaggio per migliorare l’efficienza, la qualità e la tempestività delle comunicazioni.